云网络服务介绍

2026年01月19日/ 浏览 9

目录:

1. 云网络主要服务

1.1 专有网络

1.2 物理网络

1.3 负载均衡

2. 云网络原理架构

2.1 云网络整体架构

2.2 软件定义网络SDN

2.3 网络功能虚拟化NFV

2.4 Overlay网络隧道技术

3. 云网络发展方向

3.1 DPDK网络架构

3.2 智能网卡Smart NIC

3.3 IPv4 to IPv6 改造

-------

云网络主要提供私有网络VPC,物理网络以及负载均衡等服务。主要采用了软件定义网络SDN、网络功能虚拟化NFV与Overlay网络隧道等技术。为提升网络处理性能与吞吐量,网络负载从最初采用vSW经过内核态处理,转变为采用DPDK基于用户态的处理,未来会直接卸载到智能网卡Smart NIC中处理,并采用网卡直通与SR-IOV技术实现物理设备共享。2019年11月43亿IPv4地址已消耗殆尽,IPv6改造已迫在眉睫。

1. 云网络主要服务

1.1 专有网络VPC

VPC主要功能

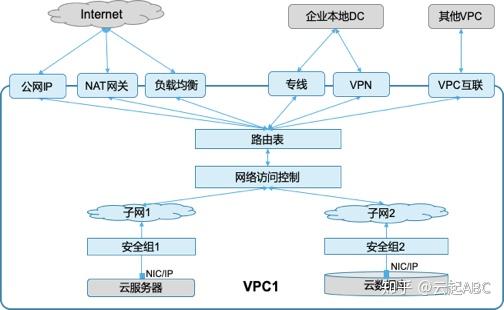

专有/私有网络VPC(Virtual Private Cloud)是逻辑隔离的云上虚拟网络空间,通过网络隧道技术实现云端多租户/多网络隔离,为云服务器或云数据库等实例提如下网络相关的服务。

1) 网络功能:创建VPC时从三个私有网段中选择合适的网段192.168.0.0/16,172.16.0.0/12, 以及10.0.0.0/8,然后创建子网,创建实例时自动分配网卡和IP地址。

2) 网络连接:同一个VPC内网默认互通,不同VPC默认隔离。实例需要与VPC外部通信时,可设置路由表与对应的连接方案。如,d通过公网IP、NAT网关或负载均衡连接互联网Internet;通过专线或VPN连接企业本地 IDC;通过VPC互联技术(如阿里云的云企业网、腾讯云的对等连接)实现跨账号/跨VPC的互联。

3) 网络安全:VPC提供安全组和访问控制列表来保障网络安全,通过四元组配置(源IP/目标IP、协议/端口、入站/出站、允许/拒绝)来限制云网络环境访问。安全组保障实例级安全,访问网控制列表保障子网级安全。

图1:VPC逻辑架构

2. VPC系统架构

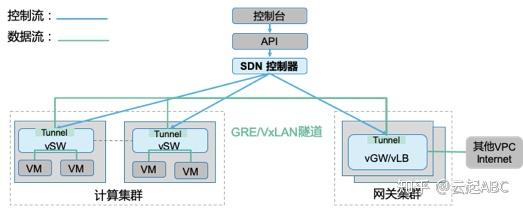

如图2,VPC的实现采用了SDN、NFV,以及Overlay隧道技术,通过三个重要组件功能实现自动化的网络配置管理与调度转发功能。

1) 控制器Controller:通过北向接口接收上层应用请求,配置 VPC网络管控/转发策略,然后通过南向接口下发配置到vSW和vGW。图中蓝色线是配置下发的控制流,绿色线是数据流。

2) 虚拟网关vGW:部署在网关服务器集群上的软件实现各种网络功能。根据控制器下发的配置对出VPC(访问其他VPC、Internet等)的流量进行处理与转发。

3) 虚拟交换机vSW:部署在业务集群服务器上,接收VM的网络数据包,根据控制器下发的配置执行VxLAN/GRE的隧道封装与转发,通过隧道ID(VPCID)实现逻辑隔离。

图2:VPC系统架构

1.2 物理网络

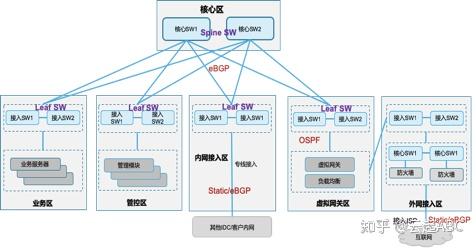

传统网络架构分为三层:接入层、汇聚层、核心层。云网络采用更加扁平高效、易于收敛与扩展的二层CLOS架构——Spine-Leaf分布式网络架构。如图3,Spine SW为核心交换机;Leaf SW为接入层TOR交换机,与传统网络二层接入层SW不同的是Leaf SW具备处理三层处理功能。Spine SW、Leaf SW之间采用eBGP协议通信,构成一个Fabric网络。每台服务器两条链路上行到Leaf SW(两两堆叠),然后再多链路上行到Spine SW,由此保障高带宽、高可靠和无阻塞的网络。

为了保障网络安全、故障隔离与便于管理运维,云网络通常分为如下区域:

核心区:提供高速转发功能。

业务区:接入部署各种云服务的服务器。

管控区:接入部署各种功能组件的服务器。

内网接入区:通过专线接入客户内部的其他IDC或网络模块,可设置静态路由或eBGP。

虚拟网关区:通过软件实现虚拟网关、负载均衡等网络功能,通过OSPF协议互联。

外网接入区:配置静态路由或eBGP接入运营商骨干网连接Internet,可部署防火墙等安全设备。

图3:物理网络架构与分区

1.3 负载均衡LB

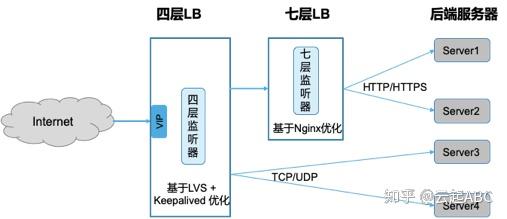

负载均衡提供流量分发服务。如图4,VIP负责统一接收前端的访问请求,监听器Listener负责执行监听规则和调度算法转发请求,后端服务器负责请求处理与反馈。负载均衡分为两类,四层LB一般基于开源的LVS(Linux Virtual Server)+ keepalived优化实现, 通过监听TCP/UDP端口进行流量分发;七层LB基于Nginx反向代理优化实现,可以监听HTTP/HTTPS,基于域名或URL地址进行流量分发,七层LB的流量需要先经过四层LB集群的处理。常用的流量分发算法有加权轮询、加权最小连接与一致性哈希算法。

在云环境中负载均衡采用NFV方式实现,通过部署在服务器集群上的软件来实现负载均衡功能。LB集群内调度节点间具有会话保持与状态同步,如果某调度节点故障,请求会转到正常节点继续处理。同时监听器会对后端服务器进行健康检查,如果某服务器节点故障,流量会动态分发到正常节点。负责均衡通常会与弹性伸缩一起使用,可基于前端请求情况进行动态的横向扩展或收缩。

图4 负载均衡架构

2. 云网络原理架构

2.1 云网络整体架构

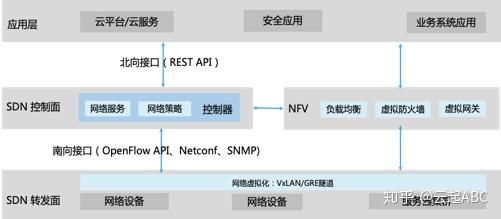

如图5,云网络中使用了三种关键网络技术:SDN、NFV,以及网络虚拟化。通过这些机制可以实现灵活高效的集中式网络控制与管理,通过普通硬件代替昂贵的专用硬件降低网络设备的成本,同时将网络边界从物理交换机延伸到部署服务器上虚拟化交换机,更好地满足云计算环境的网络要求。

图5 SDN、NFV与网络虚拟化

2.2 软件定义网络SDN

SDN(Software Defined Network)主要由网络用户和设备商发起,相关标准组织有ONF、ODL。SDN 核心是控制面与转发面分离,通过集中式的控制器,自动化配置管控,解决传统网络中因管控与转发绑定带来的各种管理运维挑战。如图5,SDN框架中上层应用通过北向接口(主要是REST API)调用控制面的SDN控制器,以使用相关网络服务或配置网络策略;然后控制器通过南向接口(主要有OpenFlow API、Netconf、SNMP等接口标准)向转发面的物理或虚拟网络设备下发配置;最后网络设备基于下发的配置执行转发或处理动作,并向上反馈状态与结果。

2.3 网络功能虚拟化NFV

NFV(Network Function Virtualization)主要由电信运营商发起,标准组织是ETSI,最初是为了降低网络采购与运营成本,将需要昂贵的专用网络设备提供且运维管理比较复杂的网络功能,通过部署在普通服务器集群上的软件来实现。NFV比较适合计算密集型的网络服务,如负载均衡、防火墙、VPN、WAN优化、深度包检测DPI等。在云环境中使用NFV实现各种虚拟网关、负载均衡等功能,也可以通过SDN控制器进行集中管控与配置下发。

2.4 Overlay网络隧道技术

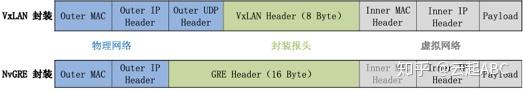

网络虚拟化有两个层面,其一是在云环境中提供各种虚拟网络功能,如VPC,虚拟网卡,虚拟交换机,虚拟路由表等;其二是通过隧道技术在底层物理网络上实现多个虚拟网络的传输。常用的隧道协议有VxLAN和GRE等,通过隧道ID(VPCID)实现VPC的逻辑隔离。隧道封装格式如图6,其中蓝色部分属于底层物理网络(Underlay网络),灰色部分属于上层的虚拟网络(Overlay网络)。阿里云采用VxLAN技术,直接封装内部的二层报文,外层加UDP(MAC-in-UDP),报头中24位的VNI字段记录VPCID,支持16M个VPC。微软采用NvGRE可以封装二层报文(MAC-in-GRE)。腾讯云的GRE封装三层报文(IP-in-GRE,去掉内层MAC,封装三层报文),报头中32位的Key字段来记录VPCID。Overlay隧道技术有两种实现形式,网络设备商倾向于在硬件交换机中完成隧道封装,而云服务商采用服务器上vSW完成隧道封装,避免对硬件网络设备的依赖。

图6 VxLAN与GRE隧道封装

3. 云网络发展方向

3.1 DPDK 架构

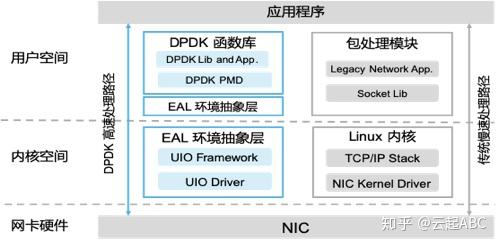

早期虚拟网络通过半虚拟化的virtio与vSW模块进行数据包处理,需要涉及内核操作,存在大量的锁、队列和中断机制等,占用系统CPU进行调度与处理,导致系统开销较大,网络性能有限。所以,Intel等公司联合推出了数据平面开发工具集DPDK(Data Plane Development Kit),通过环境抽象层EAL(Environment Abstraction Layer) ,UIO(Userspace IO)、和PMD(Poll Mode Driver)等机制大幅提高数据处理性能和吞吐量。如图7,EAL为应用提供通用的访问底层硬件或内存空间函数库与驱动集合,应用程序可以用户态调用UIO接口直接进行数据包处理,跳过内核态的协议栈处理。PMD轮询机制从网卡收到数据包后,通过DMA方式传输到预分配内存中,应用程序通过不断轮询,感知到数据包后直接进行处理。由此避免了传统NIC收到数据包后,通过中断通知CPU,同时需要从内存拷贝数据包到用户态进行处理所带来的系统开销与延迟。DPDK已开始应用于云网络环境。

图7 DPDK与传统数据包处理路径

3.2 Smart NIC/SR-IOV

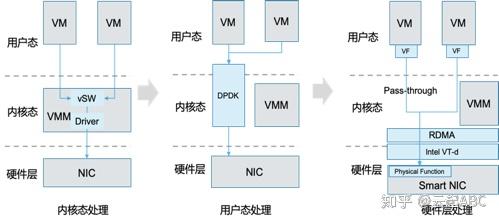

如图8,网络负载处理从最初采用vSW在内核态处理,到采用DPDK跳过内核态直接在用户态处理,大幅提升了网络性能与吞吐量。但是随着网络带宽不断突破,即将进入100G/200G/400G网络时代,DPDK性能与扩展性方面同样面临瓶颈和挑战,需要采用新的智能网卡Smart NIC技术来解决。智能网卡采用了硬件辅助虚拟化技术(如Intel VT-d),将以往通过软件实现,需要CPU调度处理的网络负载,卸载到采用高性能、可编程的FPGA芯片的硬件网卡上处理;通过远程内存访问技术RDMA直接访问内存,无需CPU的介入。云网络中通过PCI网卡直通(Pass-through)将智能网卡直接分配VM使用,同时可采用SR-IOV(Singe Root-IO Virtualization)将物理网卡端口PF映射为多个虚拟功能端口(VF),提供给多个VM共享使用。智能网卡对数据包处理性能带来巨大的突破,未来部分存储虚拟化、计算虚拟化的功能也会卸载到智能网卡中,将推动SDN、NFV、网络虚拟化,以及白牌设备的飞速发展,促进网络架构的变革。

图8: 网络负载处理情况对比

3.3 IPv4 to IPv6 改造

2019年11月43亿IPv4地址已消耗殆尽。IPv6改造已迫在眉睫,工信部已多次发文从多个层面推动IPv6改造。IPv6改造涉及多个层面:1)LTE网络端到端改造,涉及电信网络、移动终端互联等;2)网络基础设施IPv6改造,涉及骨干网、城域网、接入网等;3)以及应用基础设施改造,涉及数据中心、云服务平台、工业互联网、网站与应用等;4)IPv6网络安全保障,涉及安全能力建设、升级改造与安全管理等。IPv6改造可以通过IPv4toIPv6网关、向IPv6/IPv4双栈,最终过渡到纯IPv6网络。2019年5月,全球IPv6论坛主席Latif Ladid提到,IPv6全球普及率已达27%,中国IPv6互联网用户已超过2亿。